에이다부스트로 머신러닝 성능 높이기

에이다부스트는 머신러닝의 지도 학습 기법 중 하나로, 분류 알고리즘의 성능을 개선하는 데 효과적입니다. 기본 원리는 약한 학습기를 결합하여 강력한 모델을 만드는 것으로, 반복적인 학습을 통해 오류를 줄입니다. 각 학습기가 잘못 분류한 데이터에 더 높은 가중치를 부여하여 성능을 향상시키는 방식입니다. 에이다부스트는 다양한 분야에서 활발히 활용되며, 특히 데이터 불균형 문제를 극복하는 데 유용합니다. 이 글에서는 에이다부스트의 원리와 장점, 실제 적용 사례를 통해 머신러닝 성능 향상 가능성을 알아봅니다.

SQLD 문제 은행 앱으로 효율적으로 공부하세요!

✅ 10회차 모의고사 제공

✅ 다양한 학습 모드 (빠른문제, 집중학습, 실전모드)

✅ 상세한 통계 및 분석

✅ 완전 무료로 시작 가능

QR 코드를 스캔하여 앱을 다운로드하세요.

QR 코드를 스캔하면 자동으로 해당 플랫폼 스토어로 이동합니다.

에이다부스트로 머신러닝 성능 높이기

개념 설명

에이다부스트(AdaBoost)는 "Adaptive Boosting"의 약자로, **머신러닝의 지도 학습 기법** 중 하나입니다. 주로 **분류 문제**를 해결하기 위해 사용되며, 여러 개의 약한 학습기를 결합하여 강력한 분류기를 만드는 방법입니다. 약한 학습기란, 데이터에 대한 예측 성능이 우연히 맞추는 것보다 약간 더 나은 성능을 가진 모델을 의미합니다. 이 기법은 반복적으로 학습하는 과정을 통해 성능을 개선하게 됩니다.

원리

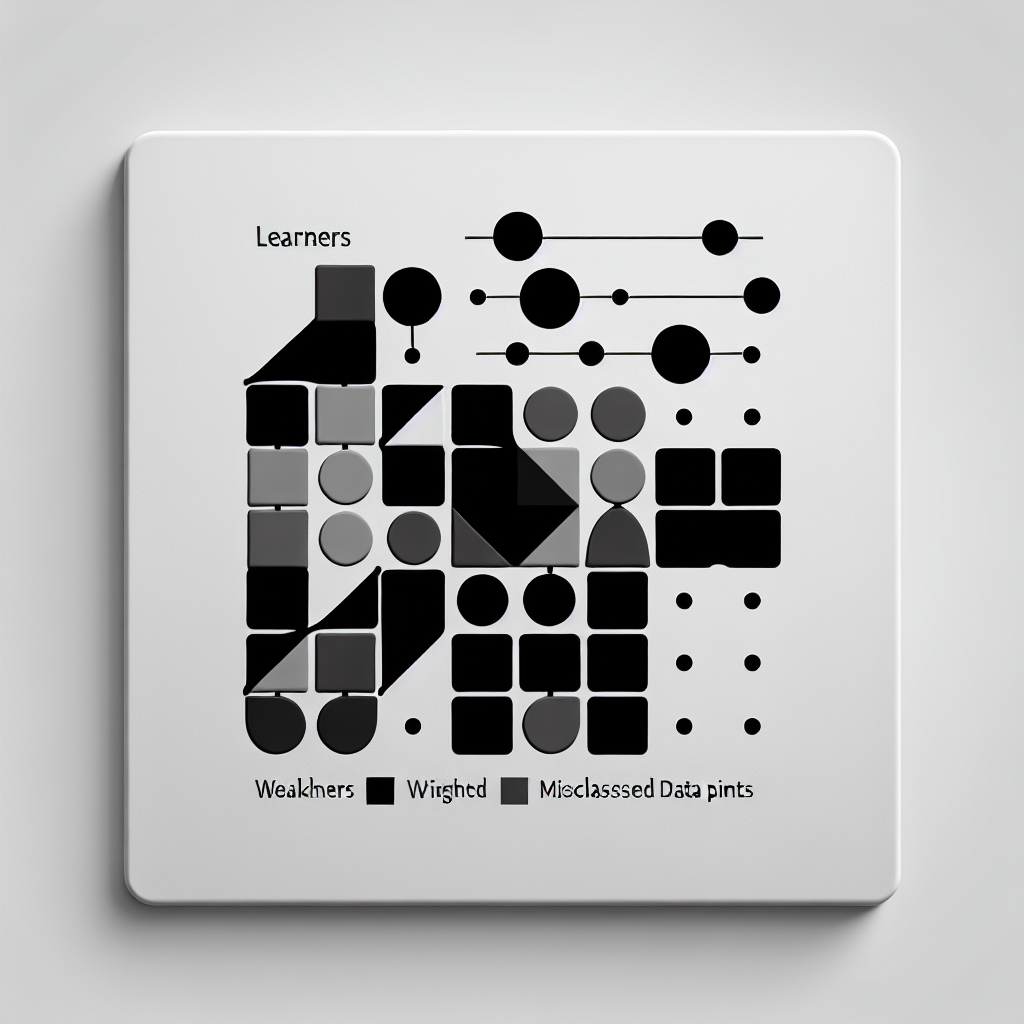

에이다부스트의 기본 원리는 **샘플 가중치 조정**에 있습니다. 처음에 모든 데이터 포인트는 동일한 가중치를 부여받습니다. 첫 번째 약한 학습기가 학습할 때, 잘못 분류된 샘플에 더 높은 가중치를 부여합니다. 이후 다음 학습기는 이 가중치를 참조하여 학습하게 됩니다. 이러한 방식은 잘못 분류된 샘플에 집중할 수 있도록 해주며, 최종 예측 모델은 모든 약한 학습기의 가중치 합으로 구성됩니다. 즉, 각 약한 학습기의 성능이 우수할수록 최종 모델의 성능이 향상됩니다.

기술 상세 내용

에이다부스트는 주로 **결정 트리**와 함께 사용됩니다. 이때 사용되는 결정 트리는 **"stump" (단일 노드 트리)** 형태로, 그 복잡성이 낮아 학습 효율성이 높습니다. 알고리즘은 아래와 같은 단계로 작동합니다:

1. **초기 가중치 설정**: 모든 샘플에 동일한 가중치를 부여합니다.

2. **약한 학습기 학습**: 가중치를 바탕으로 약한 학습기가 학습합니다.

3. **오류 계산**: 모델의 예측과 실제 값의 일치 여부에 따라 오류를 계산합니다.

4. **가중치 업데이트**: 잘못 분류된 샘플의 가중치를 증가시키고, 잘 맞춘 샘플의 가중치를 감소시킵니다.

5. **최종 모델 생성**: 여러 약한 학습기의 결과를 가중치에 따라 통합하여 최종 모델을 생성합니다.

이 과정이 반복되며, 학습을 진행할수록 모델의 성능이 향상됩니다.

장점

에이다부스트의 주요 장점은 **높은 정확성**과 **모델의 유연성**입니다. 다양한 종류의 데이터에 효과적으로 적용 가능하다는 사실은 머신러닝 분야에서 중요한 강점입니다. 에이다부스트는 **오버피팅**이 상대적으로 적고, 다양한 약한 학습기를 이용할 수 있어 실용성이 높습니다.

또한 에이다부스트는 **데이터 불균형 문제**를 해결하는 데 뛰어난 성능을 발휘합니다. 예를 들어, 주어진 데이터셋에서 특정 클래스의 샘플 수가 적을 때, 에이다부스트는 이 클래스에 대해 더 높은 가중치를 부여하여 모델의 예측 성능을 개선할 수 있습니다.

단점

하지만 에이다부스트에도 몇 가지 단점이 존재합니다. 우선, 노이즈가 있는 데이터에 대해서는 **민감한 반응**을 보입니다. 오류가 발생할 경우 잘못된 예측에 민감해져 예측 성능이 저하될 수 있습니다.

또한, **연산 속도**가 느릴 수 있는데, 큰 데이터셋에 대해 다수의 약한 학습기를 학습시키는 과정에서 시간 소모가 많을 수 있습니다. 따라서 대규모 데이터에 적용 시 주의가 필요합니다.

활용 사례

에이다부스트는 다양한 분야에서 활용되고 있습니다. 예를 들어, **의료 진단** 분야에서는 환자의 데이터를 분석하여 질병의 위험도를 예측하는 데 사용되고 있습니다. 또한, **금융 분야**에서 신용 카드 사기를 탐지하거나 **스팸 메일 필터링** 시스템에서도 효과적으로 적용되고 있습니다.

이 밖에도 **자연어 처리**(NLP) 분야와 **이미지 인식**에서도 널리 사용됩니다. 예를 들어, 뉴스 기사 분류와 같은 텍스트 데이터의 분류 작업에 에이다부스트가 도입되고 있습니다.

관련 기술

에이다부스트와 함께 주목할 만한 기술에는 **랜덤 포레스트(Random Forest)**, **서포트 벡터 머신(SVM)** 등이 있습니다. 랜덤 포레스트는 여러 결정 트리를 결합하여 예측 성능을 높이는 앙상블 기법입니다. SVM은 고차원 데이터의 분류를 위한 강력한 알고리즘으로, 에이다부스트와 결합하면 예측 성능을 더욱 향상시킬 수 있습니다.

자연어 처리 분야에서는 **딥러닝** 기술이 활발히 연구되고 있으며, 에이다부스트와 같은 앙상블 기술과 결합하여 성능을 극대화할 수 있습니다.

결론

에이다부스트는 머신러닝에서 많은 장점을 가진 분류 알고리즘으로, 특히 데이터 불균형 문제를 해결하는 데 효과적입니다. 이러한 특성 덕분에 다양한 분야에서 실질적인 예측 모델로서 그 가치를 입증하고 있습니다. 그러나 노이즈 데이터에 민감하고 연산 속도가 느릴 수 있는 점은 유념해야 합니다. 이를 통해 더욱 향상된 머신러닝 모델을 구축할 수 있으며, 관련 기술을 적절히 활용하여 성능을 극대화할 수 있습니다. 앞으로 에이다부스트가 다양한 혁신의 주도적인 역할을 할 것이라 확신합니다.

[문제]

- 에이다부스트(AdaBoost)의 기본 원리에 대한 설명으로 옳은 것은?

① 단일 강력한 학습기를 사용하는 방법이다.

② 약한 학습기를 결합하여 강력한 모델을 만드는 방식이다.

③ 모든 데이터에 동일한 가중치를 부여하여 학습한다.

④ 에이다부스트는 비지도 학습 기법이다.

정답: ② 약한 학습기를 결합하여 강력한 모델을 만드는 방식이다.

해설: 에이다부스트는 여러 개의 약한 학습기를 결합하여 강력한 예측 모델을 만드는 지도 학습 기법입니다. 각 학습기가 잘못 분류한 데이터에 더 높은 가중치를 부여하여 성능을 향상시키는 방법입니다.

- 에이다부스트가 특히 유용한 경우는?

① 모든 데이터가 균형 잡힌 경우

② 이상치(outlier)가 존재하지 않는 경우

③ 데이터 불균형 문제를 겪고 있는 경우

④ 비정형 데이터 분석에 적합한 경우

정답: ③ 데이터 불균형 문제를 겪고 있는 경우

해설: 에이다부스트는 데이터 불균형 문제를 극복하는 데 매우 유용하며, 약한 학습기를 반복적으로 학습시켜 잘못 분류된 데이터에 대한 가중치를 높이는 방식으로 성능을 개선합니다.