정책 기반 강화학습이란?

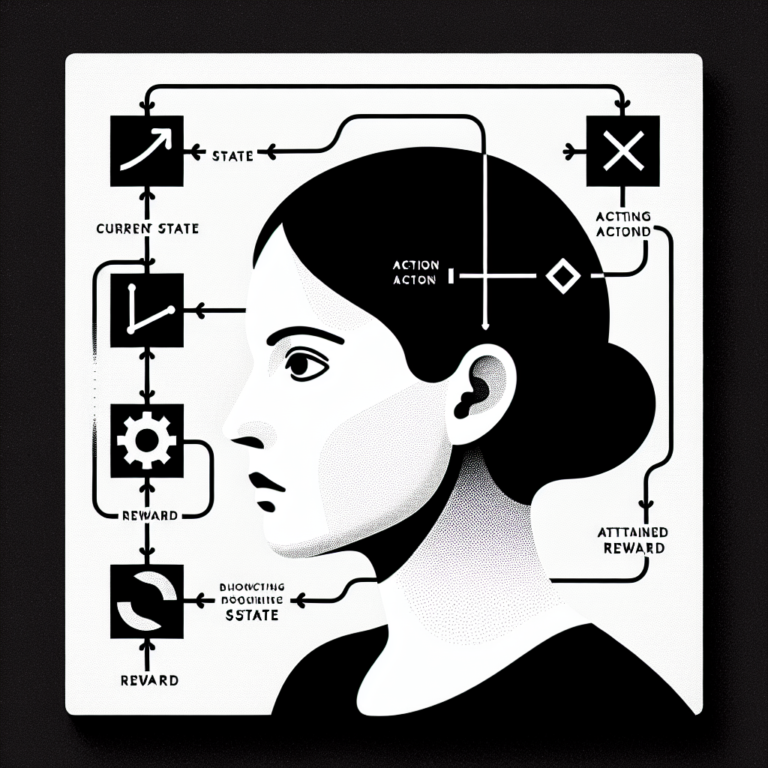

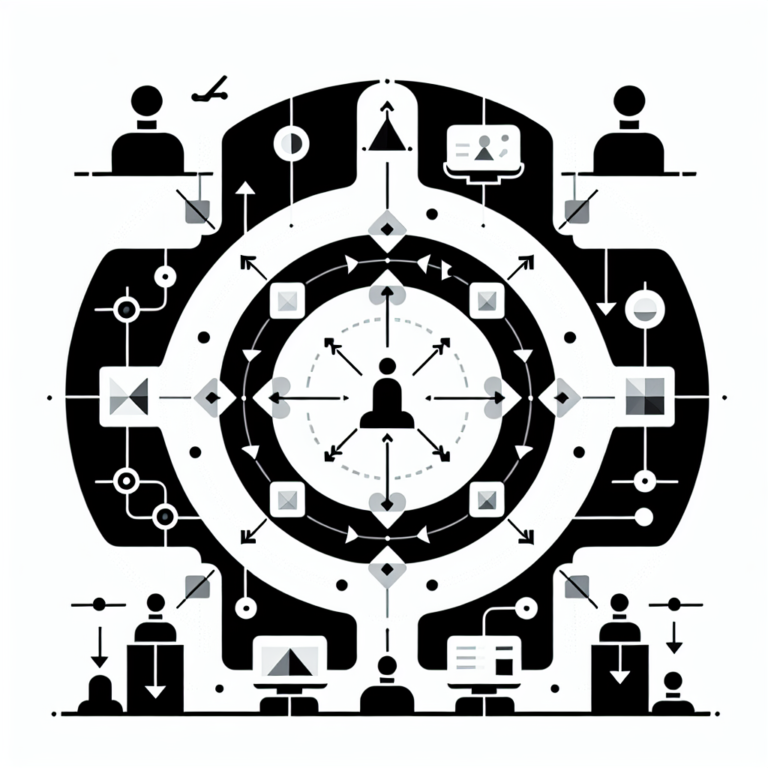

정책 기반 방법은 강화 학습의 핵심 개념 중 하나로, 에이전트가 최적의 행동 정책을 학습하는 데 중점을 둡니다. 이 방법은 상태와 행동의 관계를 기반으로 하여, 에이전트가 환경에서 얻는 보상을 극대화하도록 설계되었습니다. 다양한 알고리즘이 존재하며, 그 중 대표적인 것이 REINFORCE와 Actor-Critic 방식입니다. 정책 기반 방법은 높은 차원 공간에서도 효과적으로 적용될 수 있어 복잡한 문제 해결에 유리합니다. 이러한 방법들을 이해하고 활용함으로써 강화 학습의 이론과 실제를 더욱 깊게 탐구할 수 있습니다.