정책 경사법(Policy Gradient Methods)으로 강화 학습 이해하기

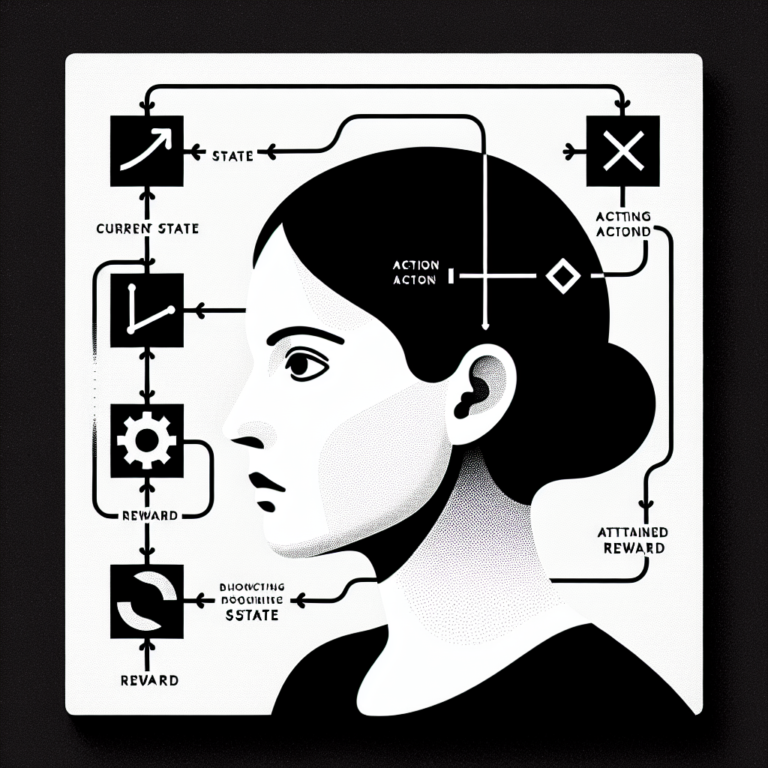

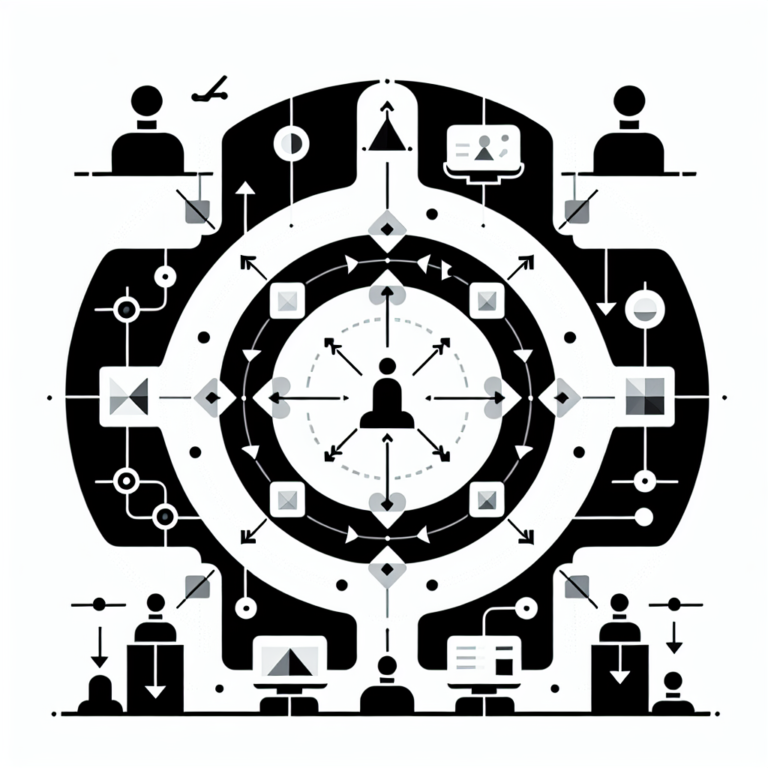

정책 경사법은 강화 학습에서 정책 기반 방법의 중요한 기법입니다. 이 방법은 에이전트가 특정 상태에서 최적의 행동을 선택할 확률을 직접적으로 학습하여 최적의 정책을 찾는 데 도움을 줍니다. 정책 경사법은 경량 모델을 가능하게 하며, 복잡한 환경에서도 유연하게 적용할 수 있는 장점이 있습니다. 또한, 이 기법은 몬테카를로 시뮬레이션과 결합하여 샘플 효율성을 높일 수 있습니다. 결국, 정책 경사법은 강화 학습에서 높은 성능을 발휘하는 핵심적인 기법으로 자리잡고 있습니다.